Mestvork&knuppels uit de stal… de ‘cloud’ is down!

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

“A networking event early this morning triggered a large amount of re-mirroring of EBS volumes in US-EAST-1,” Amazon said in a status update just before 9 am Pacific time. “This re-mirroring created a shortage of capacity in one of the US-EAST-1 Availability Zones, which impacted new EBS volume creation as well as the pace with which we could re-mirror and recover affected EBS volumes. Additionally, one of our internal control planes for EBS has become inundated such that it’s difficult to create new EBS volumes and EBS backed instances.

De verstoring kwam kort gezegd neer op de uitval van 1 van de Amerikaanse beschikbaarheids zones. De overige zones draaide wel gewoon door. Als gevolg hier van waren ook enkele andere ‘cloud’ services (voornamelijk SAAS), die boven op AWS gebouwd zijn, uitgevallen. Een lijst hier van werd gepubliceerd op http://ec2disabled.com/

Al snel zagen we dat de cloud tegenstanders de mestvorken en knuppels uit de stal hadden gehaald… want ‘de cloud’ had eindelijk zijn ware aard laten zien… en had gefaald.

Dit gebeurde al eerder, zoals mijn DatacenterPulse collega Tim Crawford in zijn blog aanhaalt:

- Oct 14, 2009 Microsoft Sidekick Data Loss

- Jun 29, 2009 Rackspace Data Center Outage

- May 14, 2009 Google Outage

- Mar 21, 2009 Carbonite Storage Failure

Ook bij deze uitval stonden mensen op de barricade te schreeuwen dat cloud niet betrouwbaar was. Voor leveranciers (en ICT-ers) waar voor de cloud ontwikkeling een bedreiging is (reëel of niet..), is dit een uitstekende gelegenheid om weer wat FUD rond te strooien. Deze tactiek haalde ik al eerder aan in mijn blog: Controle en Vertrouwen; sleutels voor cloud. Hierbij gaf ik ook aan dat het vertrouwen gemakkelijk geschaad word:

Het vertrouwen in cloud computing is iets wat gemakkelijk te schenden is. Het traditionele datacenter leeft redelijk ‘onder de radar’ als het gaat om uitval. Meestal raakt uitval daar slechts enkele applicaties of een deel van de business. Deze uitval kan wel degelijk een grote impact hebben op de productiviteit van een organisatie maar het zal nooit de mate van negatieve publiciteit krijgen die cloud providers ontvangen.

Een vliegtuig crash komt wel in het nieuws, maar de 1000-en auto ongelukken die zelfde dag meestal niet.

Opvallend was echter ook dat een aantal andere cloud services, waar van bekend is dat ze op AWS draaien, gewoon in de lucht waren. Grootste voorbeelden waren Netflix en Twilio.

Referentie architectuur…

In voorgaande blogs gaf ik ook al aan, dat cloud adoptie en migratie draait om de adoptie van een referentie architectuur van iemand ander. Je gaat aan de slag op een IAAS of PAAS omgeving die door iemand anders ontworpen en gebouwd is. Dit men hun visie en gedachte goed. Je moet je dus aan hun regels houden;

Het begrijpen van de referentie architectuur en ontwerp principes van je cloud leverancier is bijzonder belangrijk. Zowel bij IAAS, als bij PAAS geld dat je applicatie of omgeving ontworpen moet zijn voor deel-systeem uitval. Zoals in de PAAS serie aangegeven: ‘Cloud applications assume failure.’ Soms word dit ondervangen door de aangeboden frameworks, maar je moet dan wel begrijpen hoe deze werken.

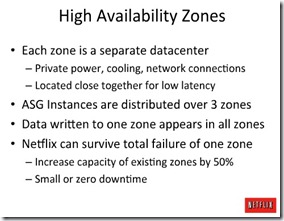

Organisaties die niet geraakt werden door de AWS uitval begrepen de architectuur optimaal en hadden hun diensten bij ontwerp en bouw al verdeeld over meerdere geografische beschikbaarheids zones, zoals NetFlix in een presentatie (slide 32-35) eerder liet zien:

Verder zijn er diverse andere mogelijkheden om redundantie in te bouwen in een AWS omgeving. Zie diverse blogs met tips:

- Why Twilio Wasn’t Affected by Today’s AWS Issues

- Cloud Outages, Redundancy, and Unicorns

- Amazon Outage Concerns Are Overblown

- How to work around Amazon EC2 outages

Systeem uitval is een dagelijkse realiteit. Rond cloud computing word vaak geroepen dat ‘cloud omgevingen niet kunnen uitvallen’. De realiteit is echter dat cloud infrastructuren ook kunnen uitvallen. Het verschil tussen cloud en traditionele infrastructuur is echter dat cloud nieuwe (technologische) mogelijkheden biedt voor redundantie en het herstarten van de dienstverlening als deze uitval plaats vind.

We moeten dus blijkbaar nog wel leren om gaan met deze nieuwe vormen van beschikbaarheid en disaster recovery (DR) 🙂