Overheidsinnovatie bij NASA

Met lichte afgunst en jalousie volg ik al enige tijd het NASA Nebula project voor Cloud computing.

Nebula is een open-source cloud computing project die een alternatief moet bieden voor de kostbare constructie van datacentra en IT infrastructuur bij de NASA. Nebula levert high performance en direct beschikbare rekenkracht, opslag en netwerk faciliteiten. Dit alles op basis van enkele bestaande en nieuw ontwikkelde open-source componenten.

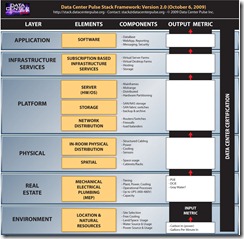

NASA heeft goed begrepen welke ingrediënten er zo al nodig zijn om deze flexibele infrastructuur en platform te kunnen bieden:

- Het fysieke datacenter voor deze oplossing is modulair gebouwd. Hierbij is voor een container gekozen.

- De onderliggende hardware bestaat voornamelijk uit het Cisco UCS systeem, welke de rekenkracht en netwerk omgeving dynamisch levert.

Een container bevat ongeveer 15.000 CPU cores of 15 petabyte aan data en het geheel is hierbij tot 50% energie zuiniger dan de bestaande IT omgevingen.

De lagen die boven op de hardware zijn gebouwd, bestaan voornamelijk uit open-source producten. Deze zijn voor een deel uit de markt gehaald en voor een deel zelf ontwikkeld. Voor al op dit laatste vlak word het interessant voor een overheids organisatie zoals NASA;

- Het gene ontwikkeld is heeft een hoog innovatief karakter.

- De ontwikkelde componenten zijn open-source en worden derhalve ook gepubliceerd en beschikbaar gesteld aan de gemeenschap.

- Een deel van de componenten zijn gedoneerd aan de OpenStack (het open-source, open-standaarden Cloud project)

- Men gebruikt voornamelijk open standaarden.

Het bovenstaande zijn allemaal karakteristieken die meestal slecht passen bij de bureaucratische en behoudende mentaliteit van overheidsorganisaties.

Ray O’Brien (Nebula Program Manager) schrijft daar over in zijn blog:

Innovation doesn’t always come easily… especially in a large federal government agency. True, rules and regulations are needed to manage behemoth organizations and protect taxpayers, but this always has to be balanced so that creativity and innovation are nurtured, not stifled. The senior NASA managers responsible for the oversight of Nebula understand this key point.

How does Nebula do it? The answer is that Nebula functions more like a tech start-up and less like a legacy organization. Critical to making it work: a phenomenal team of talented professionals and the effective use of modern day communications.

Ik mag een groot deel van mijn werkzame leven al door brengen in overheidsorganisaties.. dus ik herken waar hij het over heeft. Het succes van dit project (onderschreven door de landelijk CIO Vivek Kundra) dwingt dan ook groot respect af. De ontwikkelde Nebula omgeving is ook nog eens de motor onder een groot deel van de Apps.gov omgeving voor diverse overheidsinstellingen.

Een project dat innovatie combineert met groen, flexibel, cloud, open-source, open-standaarden, dynamische infrastructuur en een modulair datacenter… binnen de overheid ?!? Ik meld me meteen aan !